Artykuł jest analizą merytoryczną dowodów, na które powołano się w proteście wyborczym przeciwko ważności wyborów Prezydenta RP przeprowadzonych w dniu 1 czerwca 2025 roku. Jest ich kilka, wszystkie statystyczne, i jak pokażę, powoływanie się na nie jest błędem.

Jeden z dowodów opiera się na modelu opisanym na stronie defoliator.pl, który rzeczywiście może być użyty do wskazania komisji, w których mogło dojść do naruszeń. Jak jednak pokażę, nie pozwala na wyciąganie wniosków, że było ich wiele i głównie na korzyść jednego z kandydatów. Przy okazji zaprezentuję swoje podejście do budowy tego typu modeli.

Dodatkowo w tym artykule omawiam błędy popełnione przez dr. Krzysztofa Kontka w jego modelu detekcji anomalii.

Rozkład Benforda

Przy pewnych założeniach, częstość występowania pierwszych cyfr w liczbach rozkłada się w pewien określony sposób: cyfra 1 występuje w około 30,1% przypadkach, cyfra 2 17,6% itd. Główne założenia:

- liczby mają wiele rzędów wielkości (setki, tysiące, miliony itd.),

- liczby powstają w pewnym naturalnym procesie (nie są sztucznie ograniczone).

Przykłady to długości rzek, rozmiary populacji zamieszkujących określony teren czy stałe fizyczne.

Według autorów protestu, fakt, że dane wyborcze nie są zgodne z tym rozkładem, ma być „silną przesłanką manipulacji”. Jak pokażę, nie tylko nie jest to silna przesłanka, ale powołanie się na ten rozkład jest błędem.

Liczba uprawnionych

Aby porównanie z rozkładem Benforda miało sens, trzeba najpierw uzasadnić, że mamy do czynienia z liczbami, które powinny się w ten sposób rozkładać. Nie znajduję dobrego uzasadnienia w przypadku liczby głosów oddanych w każdej komisji na danego kandydata. Przeciwnie: liczba głosów silnie koreluje z liczbą uprawnionych, a wielkość komisji jest tak “zaprojektowana”, aby nie była ani za duża, ani za mała. Z danych PKW wynika, że liczba uprawnionych do głosowania to w 55,9% przypadków liczba 3-cyfrowa, a w 40,5% liczba 4-cyfrowa, czyli mamy dwa rzędy wielkości. Dodatkowo liczby 4-cyfrowe są w prawie 90% przypadków z przedziału 1000-1999, stąd można się spodziewać nadreprezentacji cyfry 1.

Na poniższym wykresie porównanie z rozkładem Benforda dla liczby uprawnionych. Jak widać, rozkład ten nie ma tutaj zastosowania (zgodnie z przewidywaniami, cyfra 1 występuje zdecydowanie zbyt często). Stąd moim zdaniem nie mamy prawa zakładać, że przy tylko dwóch kandydatach liczba głosów na któregoś z nich będzie z takim rozkładem zgodna.

Liczba głosów

Mimo powyższych wątpliwości (które moim zdaniem są wystarczające), przejdźmy do analizy liczby głosów. Poniżej rozkład pierwszej cyfry dla Nawrockiego w 2. turze. To ten wykres pojawia się w proteście wyborczym.

Odstępstwo jest bardzo duże, co ma świadczyć o tym, że “manipulacje dotyczyły wyników tego kandydata” (cytat z protestu). Porównajmy z liczbą głosów na Trzaskowskiego.

Odstępstwo już również duże, choć mniejsze. Zaraz pokażę, z czego to wynika, ale sprawdźmy jeszcze, czy liczba głosów oddanych na Dudę w poprzednich wyborach jest zgodna z rozkładem Benforda.

Jeśli brak zgodności z tym rozkładem miałby świadczyć o manipulacjach, to wygląda na to, że w poprzednich wyborach były znacznie większe. Tak naprawdę musiałyby być systemowe (w większości komisji).

Dlaczego liczba głosów dla Trzaskowskiego odbiega od rozkładu Benforda w mniejszym stopniu? W poniższej tabeli podaję, jak często liczba głosów na danego kandydata jest liczbą n-cyfrową (w procentach).

| Liczba cyfr | Duda 2020 | Nawrocki 2025 | Trzaskowski 2025 |

|---|---|---|---|

| 1 | 0.68 | 1.10 | 1.68 |

| 2 | 6.46 | 10.26 | 29.38 |

| 3 | 92.06 | 88.08 | 64.88 |

| 4 | 0.80 | 0.57 | 4.06 |

Jak podano wcześniej, 4-cyfrowa liczba uprawnionych to były głównie liczby 1000-1999, w takim razie liczba głosów na kandydata bardzo rzadko jest liczbą 4-cyfrową. W przypadku Dudy w aż 92% mamy tylko liczby 3-cyfrowe (stąd rozkład w ogóle nie przypomina Benforda), dla Nawrockiego w 10% przypadków występują też liczby 2-cyfrowe, a dla Trzaskowskiego w 29% — stąd rozkład dla niego najbardziej przypomina Benforda. A te różnice wynikają stąd, że Duda i Nawrocki wygrywali głównie w mniejszych komisjach (na wsi).

Dodam, że jeśli zdecydowana większość liczb jest tego samego rzędu, to rozkład pierwszej cyfry jest po prostu przybliżeniem histogramu. Rozkład liczby głosów oddanych na Dudę jest mniej więcej normalny, z maksimum w przedziale 300-399, stąd cyfra 3 jest najpopularniejsza.

Podsumowując, liczba głosów rzeczywiście znacznie odbiega od rozkładu Benforda. Powodem jest to, że w ogóle nie powinna tak się rozkładać.

Ruski ogon

Poniższy wykres prezentuje rozkład frekwencji w drugiej turze: w ilu komisjach odnotowano daną frekwencję, po zaokrągleniu do jednego procentu. W większości komisji zagłosowało od 60% do 80% uprawnionych.

Według autorów protestu wyborczego, na tym wykresie ma być widać tzw. “ruski ogon”, czyli nadwyżkę komisji z bardzo wysoką frekwencją, bliską 100%. Ma być to “sygnałem możliwych korekt kart lub innych anomalii w procesie wyborczym”.

Przybliżmy wykres, skupiając się na jego prawym ogonie (frekwencja co najmniej 90%).

Rzeczywiście, wydaje się, że jest pewna nadreprezentacja komisji z frekwencją 100% po zaokrągleniu (liczba komisji dla 99% odpowiada tempu spadku). Jest 119 takich komisji.

Zacznijmy od tego, że w ponad połowie z nich frekwencja w pierwszej turze również była bardzo wysoka (powyżej 90%). Po drugie, 63% z nich to komisje z liczbą uprawnionych poniżej 100. Po trzecie, spójrzmy, co to za komisje:

| Typ komisji | N |

|---|---|

| zakład leczniczy | 64 |

| dom pomocy społecznej | 25 |

| zagranica | 15 |

| stały | 10 |

| oddział zewnętrzny zakładu karnego | 3 |

| dom studencki | 1 |

| statek | 1 |

Oczywiście nie ma w tym nic dziwnego, że w zakładach leczniczych i DPSach frekwencja może być bardzo wysoka (powodów jest wiele, między innymi wszystkie osoby są często na miejscu). W przypadku komisji zagranicznych wyborcy specjalnie muszą się zapisać, więc wysoka frekwencja też jest naturalna (we wszystkich tych komisjach w pierwszej turze też taka była). Zostało 10 stałych komisji, ale zauważmy, że tylko część komisji z bardzo wysoką frekwencją można uznać za “nadmiarowe”. Poza tym, gdyby wybory odbyły się tylko w tych “podejrzanych” stałych komisjach, Trzaskowski otrzymałby ok. 62% głosów (a 68% we wszystkich komisjach z frekwencją co najmniej 90%).

Głosy nieważne

Jak twierdzą autorzy protestu, w drugiej turze wyborów wystąpił “ponadstandardowy wzrost głosów nieważnych, gdzie podwójnie zaznaczono kandydatów”, na dodatek w komisjach, w których w pierwszej turze wygrał Trzaskowski.

Procent głosów XX (nieważnych z podwójnym X) rzeczywiście się zwiększył, w drugiej turze było ich 3,75 razy więcej niż w pierwszej. W poprzednich wyborach prezydenckich (2020) również tak było, a nawet wzrost był jeszcze większy, wynosił 4,85 razy. Nie wiadomo zatem, co autorzy mają na myśli jako “ponadstandardowy” wzrost. Z jakim standardem się porównują?

Dodajmy, że taki wzrost jest logiczny, bo część osób może nie znaleźć swojego kandydata w drugiej turze, o co łatwiej w pierwszej, gdy jest ich więcej. W takim wypadku można albo nie pójść na wybory, albo oddać nieważny głos.

Ale jak rozumiem, kluczowym argumentem jest tu to, że ten wzrost “zależał” od tego, kto wygrał w pierwszej turze: jeśli Trzaskowski, wzrost był większy. Napisałem “zależał” w cudzysłowie, bo autorzy nawet nie próbują pokazać, że jest to zależność przyczynowa, po prostu informują o korelacji. A cóż z tego, że ona istnieje? Przecież nie ma żadnych powodów, żeby wzrost głosów XX był równomierny. Skoro komisje różnią się poparciem dla Nawrockiego i Trzaskowskiego, to dlaczego nie miałyby się różnić wzrostem nieważnych głosów w drugiej turze? To zadaniem autorów analizy jest przekonanie nas, że jest to nienaturalne.

Mimo wszystko, pociągnijmy ten temat. Po pierwsze, mimo wielu prób, nie byłem w stanie otrzymać liczb, które podano w proteście. Jeśli ktoś jest w stanie wytłumaczyć, co oznacza np. wzrost 27,6% w dolnośląskim (w komisjach, w których wygrał Nawrocki), prosiłbym o wiadomość. Wbrew podpisowi tabeli, to raczej nie jest wzrost głosów XX, bo on był znacznie większy.

Poniżej liczę to inaczej: sumuję wszystkie głosy XX z drugiej tury i sprawdzam, ile razy jest ich więcej w stosunku do pierwszej tury, w zależności od tego, kto wygrał w pierwszej turze. Dla porównania robię to samo dla poprzednich wyborów.

| Rok | Wygrana | Wzrost XX |

|---|---|---|

| 2025 | Nawrocki | 3.32 |

| 2025 | Trzaskowski | 4.04 |

| 2020 | Duda | 3.19 |

| 2020 | Trzaskowski | 4.83 |

W komisjach, w których wygrał Trzaskowski (tzn. zdobył więcej głosów od Nawrockiego), podwójnych X jest 4,04 razy więcej, a w komisjach, w których wygrał Nawrocki, 3,32 razy. W 2020 roku różnica była większa, więc podobnie jak z rozkładem Benforda, trzeba by uznać, że w tamtych wyborach problem był jeszcze większy.

Natomiast w tych liczbach nie widać niczego niepokojącego, bo jak pisałem, nie ma żadnych powodów, żeby wzrost podwójnych X był równomierny. Mimo wszystko, spróbuję wskazać jedną z potencjalnych przyczyn tych różnic.

(Ta część analizy jest dość zaawansowana i wymaga wiedzy, czym jest kontrola czynników zakłócających w modelach statystycznych).

Najpierw przedstawmy problem inaczej. Na osi X zaznaczyłem różnicę poparcia między Trzaskowskim i Nawrockim w pierwszej turze (w punktach procentowych), na osi Y różnicę w procencie nieważnych głosów (nie iloraz, jak wcześniej; w ten sposób łatwiej będzie zbudować model).

Niebieska krzywa to model GAM; wartości na tej krzywej możemy interpretować jako średnią różnicę w nieważnych głosach w komisjach, w których przewaga Trzaskowskiego wynosiła konkretną wartość, np. 25 p.p. Ograniczyłem się do komisji, w których zagłosowało co najmniej 400 osób oraz odrzuciłem odstające przypadki, gdy przewaga Trzaskowskiego wynosiła ponad 50 p.p. Dodatkowo rozważam tylko komisje, w których zarówno w pierwszej, jak i drugiej turze, pojawił się choć jeden głos XX, bo poprzednie obliczenia też były wykonywane tylko dla takich komisji.

Widzimy coś rzekomo niepokojącego: im więcej głosów otrzymał Trzaskowski w pierwszej turze, tym więcej nieważnych głosów pojawiło się w drugiej. Czy da się to wyjaśnić?

Na kolejnym wykresie widzimy, że w komisjach, w których Trzaskowski zdobył więcej głosów w pierwszej turze, Zandberg również.

Czyli informacja, że Trzaskowski otrzymał więcej głosów od Nawrockiego, jest też informacją, że w danej komisji było więcej sympatyków Zandberga. Co zrobiły te osoby w drugiej turze? Zapewne większość zagłosowała na Trzaskowskiego, ale być może część stwierdziła, że odda nieważny głos (Zandberg nikogo nie poparł). Dodajmy, że wystarczy niewielka liczba takich osób, by wytłumaczyć zaprezentowane wcześniej “podejrzane” różnice.

Czy da się to zweryfikować na podstawie dostępnych danych? Spróbujmy wyjść poza proste korelacje i zbudujmy model, w którym uwzględnimy więcej zmiennych jednocześnie. Różnicę w głosach XX wyjaśniam przy pomocy wyników pierwszej tury: różnicy poparcia Trzaskowskiego i Nawrockiego, poparcia Zandberga, Mentzena itd. (pominąłem jedynie Maciaka i Wocha, bo otrzymali bardzo mało głosów). Poniższe zależności powstały na bazie takiego modelu (zależności dla pozostałych kandydatów są bardzo słabe).

Jak widać, im więcej głosów otrzymało tych trzech kandydatów (Zandberg, Hołownia, Stanowski), tym średnio więcej nieważnych głosów pojawiło się w drugiej turze. Jednym z wyjaśnień może być to, że część z wyborców, którzy poparli tych kandydatów, zdecydowała się w drugiej turze oddać głos nieważny. Ale najważniejsze, że znika zależność z różnicą poparcia Trzaskowskiego i Nawrockiego.

Dodajmy, że R2 dla modelu wynosi jedynie 8%, a w takim razie procentu głosów XX nie da się wyjaśnić przy pomocy wyników pierwszej tury. Natomiast jest to wystarczające, by zniknął “podejrzany” wzrost takich głosów w komisjach, w których wygrał Trzaskowski.

Model detekcji anomalii

W tej części analizuję model opublikowany na blogu defoliator.pl, który będę nazywał modelem Def. Jest to najbardziej zaawansowane podejście do szukania potencjalnych nieprawidłowości i w zasadzie jedyne w proteście, które potencjalnie ma sens. Co więcej, właśnie przy pomocy tego typu modeli wytypowano komisje, w których zamieniono wyniki kandydatów w drugiej turze, co następnie zostało potwierdzone.

Rozumowanie opiera się na założeniu, że na podstawie wyników pierwszej tury w danej komisji oraz ogólnopolskiego (szacowanego) przepływu głosów da się wystarczająco dokładnie przewidzieć wyniki drugiej tury. Na tyle, by wskazać przypadki tak odstające, że rozsądnie jest przeliczyć tam głosy jeszcze raz.

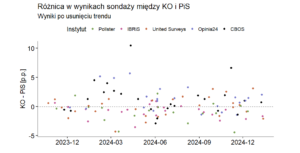

Autor przyjmuje pewien próg, przy którym uznaje, że wyniku drugiej tury nie da się wyjaśnić wynikiem pierwszej. Na tej podstawie kwalifikuje ok. 1000 komisji jako anomalie. Co ważne, okazuje się, że nie ma w nich symetrii: w 80% z nich potencjalne pomyłki wystąpiły na korzyść Nawrockiego, a w 20% Trzaskowskiego.

Tutaj prezentuję moje podejście, przy pomocy którego doszedłem do zupełnie innych wniosków: co najwyżej kilkadziesiąt komisji, które można uznać za anomalie, oraz symetryczny ich rozkład (podobna liczba z korzyścią dla Trzaskowskiego i Nawrockiego). Istotą mojego podejścia jest typowanie komisji, w których z dużym prawdopodobieństwem oficjalne wyniki są nieprawidłowe. Podkreślam tu słowo prawdopodobieństwo, bo w modelu Def mówienie o nim jest utrudnione, a wnioskowanie odbywa się na ocenie, czy różnica między oficjalnym wynikiem a symulowanym jest “duża”. W szczególności, nie jesteśmy w stanie oszacować, ile fałszywie dodatnich wyników powinniśmy się spodziewać. Jeśli wyniki modelu mają być argumentem za tym, że doszło do poważnych naruszeń – takich, które mogły zmienić ogólnopolski wynik — musimy zadbać o to, by fałszywie dodatnich wyników było jak najmniej. Co prawda w niektórych przypadkach możemy sobie pozwolić na większą ich liczbę (np. jeśli mamy inne mocne argumenty, że doszło do fałszerstw), ale w dalszym ciągu powinniśmy mieć kontrolę nad liczbą takich błędów.

Oprócz tego, w przypadku reszt studentyzowanych, z których korzystam, istnieją powszechnie przyjęte progi, przy których uzasadnione jest mówić o anomalii. Co ważne, ten próg jest dostosowany do jakości modelu. Jeśli jest dokładny, jesteśmy w stanie wykryć więcej anomalii (mamy większą pewność, że konkretna różnica między prognozą a oficjalnym wynikiem to nie jest kwestia przypadku, ale błędu lub oszustwa).

Drugim problemem z modelem Def (który przy pewnych założeniach może być traktowany jako zaletę, o czym zaraz) jest fakt, że bardzo mocno zależy on od przyjętych parametrów opisujących przepływy, które muszą pochodzić z sondażu. Jeśli nie będą wystarczająco bliskie rzeczywistym, model może zwyczajnie nie działać, wskazując złe komisje. Co gorsza, w konkretnym kierunku, tzn. więcej na korzyść jednego z kandydatów. Moim zdaniem to jest niedopuszczalne.

Zauważmy też, że tak dużo obserwacji odstających wskazanych przez model Def (ponad 1000) oraz brak symetrii w różnicach między prognozą a rzeczywistymi wartościami są zwykle w statystyce argumentem za tym, że przyjęto złe założenia. Dlatego takie modele nadają się raczej tylko do wskazywania pojedynczych anomalii.

Dodajmy jednak, że przy założeniu, że przyjęte parametry są poprawne, takie podejście umożliwia wykrycie również systemowych oszustw, w znacznie większej liczbie komisji, niż w moim podejściu. W szczególności można oszacować “prawdziwy” wynik wyborów. Ale nie widzę możliwości, byśmy mogli być wystarczając pewni tego założenia i nie zachęcam do stosowania takiego podejścia.

Referencje

Obliczenia wykonano w języku R, kod dostępny tutaj.

- Wyniki wyborów 2015

- Wyniki wyborów 2020

- Wyniki wyborów 2025

- Protest

- Benford’s Law and the Detection of Election Fraud (dlaczego prawo Benforda to kiepskie narzędzie do analizy oszustw wyborczych)

- defoliator.pl